Доброго времени суток, друзья! В сегодняшней небольшой заметке мы продолжим тему оптимизации сайта, а именно поговорим об такой терминологии, как сопли Гугла. Забавно, как люди изобретательно могут извращать некоторые названия, присваивая англоязычным заумным терминам понятные для славянского пользователя слова. И вот тот, кто впервые столкнулся с этим словечком, недоумевает, каким боком насморк относится к индексации сайта?

Что такое Гугл сопли?

Сопли Google (supplemental index) – это дополнительный индекс, т.е. страницы, которые находятся не в основном индексе результатов Google. Распилив слово «supplemental» на две равные части получилось слово созвучное с простудным симптомом - supple/сопли.

Проще говоря, supplemental index принято называть страницы, которые, по мнению западной поисковой системы Гугл, являются недостаточно хорошими, чтобы попасть в основной индекс.

Каждая новая публикация в Гугл проходит тщательную проверку на предмет соответствия критериям основанного индекса. В процессе детального анализа, система, учитывая множество факторов, определяет, соответствует ли страница критериям основного индекса. Количество страниц, попавших в дополнительный индекс, может стремительно расти в связи с ранее допущенными нарушениями. Поэтому очень важно проводить систематический анализ сайта и при обнаружении дополнительного индекса своевременно бороться с природой его возникновения.

Если на вашем веб-проекте ощутимо упал трафик, вполне возможно, что на нем обнаружены существенные нарушения, спровоцировавшие поисковик Гугл отправить массу ранее релевантных страниц в дополнительный индекс. Порой подобная неприятность возникает даже на самых качественных ресурсах, поэтому ненужно впадать в крайности и паниковать.

Как проверить сопли Гугла?

Для начала нужно определиться, какие старицы относятся к дополнительному индексу. Для этого в поисковой строке Google вставляем следующую строку:

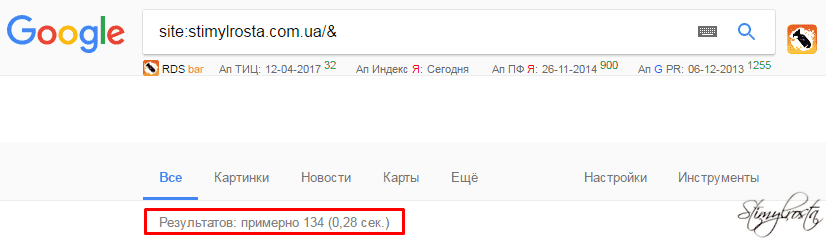

site:stimylrosta.com.ua/& - количество страниц, находившихся в основном индексе Google

Вместо stimylrosta.com.ua пропишите название своего домена. Взглянув на предоставленный скриншот, можно заметить, что в индексе находится 134 страницы. Для моего блога эта цифра является хорошим показателем, так как является практически идеальной по соотношению к количеству опубликованных статей.

Для проверки всех страниц в независимости от дополнительного либо основного индекса в Гугл необходимо прописать следующую команду:

site:stimylrosta.com.ua - общее количество страниц проиндексированных Google

Сопоставив разницу между двумя результатами, можно определить какое количество страниц находится в дополнительном индексе.

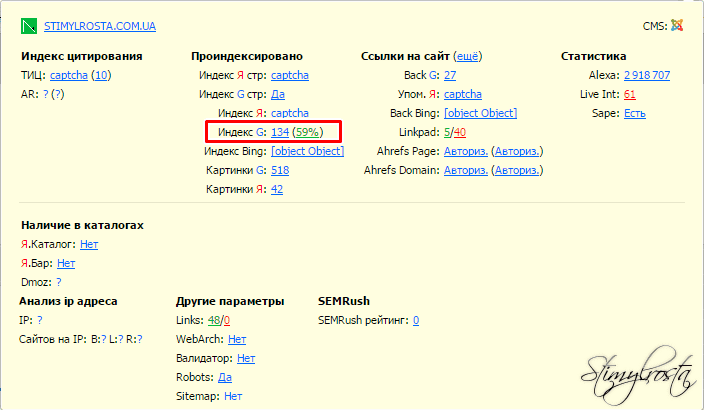

Замечательной альтернативой проверки сайта является плагин для SEO анализа RDS Bar. Вот как это выглядит на деле.

Забавно, что используя вышеприведенный способ на моем веб-ресурсе, количество «соплей» равнялось нулю. При этом, проанализировав сайт при помощи плагина RDS Bar, основной индекс составил 59%. Может быть, вы знаете, в чем причина такой существенной разбежности?

Как удалить образовавшуюся «сопливость»?

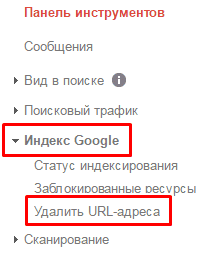

Обнаружив при помощи вышеприведенного способа сопливость на своем проекте, от нее необходимо избавиться. Для этого требуется, чтобы ваш сайт был добавлен в Гугл Вебмастер. И так авторизируемся. Здесь нам понадобится вкладка Индекс Google/Удалить URL-адреса.

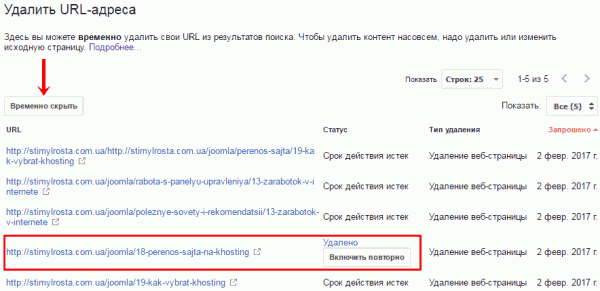

На открывшейся странице необходимо нажать кнопку «Временно скрыть» и в открывшуюся строку вставить ранее скопированный в буфер обмена URL страницы, которая попала в дополнительный индекс.

Представленный метод позволяет лишь временно удалить URL-адреса. Со слов самого сервиса для того, чтобы удалить контент насовсем, надо удалить или изменить исходную страницу. Подробнее читайте справку Search Console.

Если же выполнить действие, отвечающее за временное скрытие, ссылки исчезнут из поиска Гугл на 3 месяца. Как правило, процесс исключения занимает не более суток. Но по своим собственным наблюдениям я обнаружил, что систематическое удаление все же действует, и некоторые урлы исчезают с результатов поиска насовсем.

Причины, по которым страницы попадают в сопли

- Плохо оптимизированный, неуникальный контент.

- Несоответствие страницы основной тематике сайта.

- Отсутствие минимального количества контента.

- Дубликаты страниц.

- Отсутствие title и descriptin.

Вполне возможно список не полный. Если у вас есть что сказать по этому поводу, выскажитесь в комментариях.

Сопливые страницы являются явной проблемой к достижению повышения трафика, поскольку посетителей владельцам сайтов с них не видать. Это настоящая проблема, которая усугубляется еще и тем, что поисковые боты неохотно посещают дополнительный индекс. И даже если все нарушения исправлены, обновление данных можно ждать еще очень долго.

Важный момент! Если у вас сайт создан на какой-нибудь CMS, дубликаты страниц генерируются самим же движком. Если же проект самописный, подобных проблем возникать не должно. И что самое главное – нет дублей, нет и соплей.

На этом у меня все! Пускай ваши сайты не хворают, а все станицы находятся исключительно в основном индексе ?.

И помните, каждый автор, написавший полезную статью, заслуживает на комментарий, минимум репост.

Спасибо за внимание и до скорого на страницах Stimylrosta.

Обнаружили в тексте грамматическую ошибку? Пожалуйста, сообщите об этом администратору: выделите текст и нажмите сочетание горячих клавиш Ctrl+Enter

так что завтра, похоже, буду вытаскивать из соплей сайт, спасибо за информацию!!

у меня, как моно посмотреть самим - 56 %. это крах системы, проект писал на ВП грамотным специалистом.

возможно, что влияет отсутствие команды "добавить УРЛ" (сори за мой французский) в новые сайты при добавлении статьи. раньше добавляла, потмо перестала