Дубли страниц — весьма распространенная SEO-ошибка, которая может возникать вследствие некорректных настроек CMS, изменения структуры сайта и ошибок, допущенных вебмастерами. Наличие дубликатов может повлечь за собой серьезные последствия и свести все усилия, связанные с продвижением веб-проекта, на нет. В текущей статье мы рассмотрим, чем плохи дубли страниц, как найти их и убрать.

Что такое дубли страниц сайта и почему от них нужно избавиться

Дубли страниц — это определенные страницы сайта, содержащие частично или полностью одинаковый контент.

По сути, это два или больше уникальных URL-адреса с одинаковым или отчасти повторяющимся содержанием.

Чем плохи дубли страниц? Когда на сайте есть несколько одинаковых страниц, поисковые системы не могут понять, какую из них нужно показывать пользователям по релевантному запросу. Вследствие вместо приоритетных страниц в основном поиске могут оказаться дубли, которые наоборот нужно убрать из сайта и исключить из поиска.

Если ничего не предпринимать и оставить все на самотек, понадеявшись на алгоритмы поисковых систем, последствия могут быть очень серьезными:

- Проблемы с индексацией. Допустим, вы владелец интернет-магазина с несколькими тысячами страниц, на каждую из которых из-за неправильных настроек системы управления сайтом автоматически генерируется по одному дубликату. При таких обстоятельствах общий размер сайта увеличивается, а количество страниц, которые поисковый робот может просканировать на сайте за один раз, остается прежним. Таким образом во время очередного визита новые нужные страницы могут остаться не у дел.

- Изменения релевантной страницы в выдаче. Поисковый алгоритм в любой момент может посчитать дубль более релевантным запросу. Смена страницы в поисковой выдаче часто сопровождается существенным понижением позиций.

- Неправильное распределение внутреннего ссылочного веса. В процессе наполнения сайта очень важно связывать страницы между собой, делать так называемую внутреннюю перелинковку. Правильная внутренняя перелинковка положительно влияет на поведенческие факторы, качество индексации, распределение статического и динамического веса между страницами. Однако, если изменить структуру проекта, образуются неправильные внутренние ссылки, ведущие на страницы (дубли), которые поисковики могут посчитать более значимыми.

- Потеря естественной внешней ссылочной массы. Если опубликованный на вашем ресурсе материал будет действительно интересным и полезным, есть вероятность того, что пользователь захочет поделиться им с друзьями. Как мы знаем, получение естественных ссылок — сложный процесс, требующий внимания к деталям, анализа множественных факторов, знаний и навыков. Кроме того — это дорого (если задачу поручить линкбилдеру) и времязатратно (если заниматься этим самому). И тут вдруг вашим контентом хотят безвозмездно поделиться. Стоит ли пренебрегать такой возможностью?

Статья по теме: Что такое крауд-маркетинг, кому он нужен и где его заказать

Очевидно, дубликаты страниц на сайте оказывают негативное влияния на продвижение, следовательно, этому вопросу нужно уделять должное внимание.

Виды дублей

Как выше уже было сказано, дубликаты страниц бывают двух типов: полные и частичные.

Полные дубли

Полные дубли — страницы с полностью одинаковым контентом, доступные по разным URL.

Чтобы было проще ориентироваться, рассмотрим самые распространенные полные дубли страниц:

- Версия с/без www. Возникает, если пользователь не указал главное зеркало — адрес, который участвует в результатах поиска.

https//www.site.com

https//site.com

- Дубли страниц с html и https протоколом.

http//site.com

https//site.com

- Дубли страниц с и без слеша «/» в конце URL.

https//site.com

https//site.com/

- Страницы с и без суффиксов index.php, index.html, home.php, home.html.

https://site.com

https://site.com/index.php

https://site.com /index.html

https://site.com/home.php

https://site.com/home.html

- Проблемы с иерархией разделов, которые генерируют копии.

https://site.com/catalog/dir/products

https://site.com/catalog/products

https://site.com/products

https://site.com/dir/products

- URL-адреса страниц в верхнем и нижнем регистрах.

https://site.com/category

https://site.com/CATEGORY

https://site.com/Category

- Дополнительные UTM-метки, которые используются, чтобы передавать данные для анализа рекламы и источника переходов. Создаются с помощью генератора UTM, либо просто руками. Всё зависит от того, какие именно переходы вам нужно отслеживать. Добавляются в конце URL через знак вопроса «?».

https://site.com/winter_sale?utm_source=google&utm_medium=search&utm_campaign=zhenskie-hudi&utm_content=ad1&utm_term=zhenskie-hudi-s-kapyushonom

- Страницы с GET-параметрами. Позволяют передать определенные показатели, например, номер товара или номер заказа. В URL-адресе обязательно содержится знак «?», после которого следует GET-параметр. Если интернет-магазин отдает ответ с кодом 200 на любые GET-параметры, которые не определены заранее, возникают дубли.

https://site.com/products/man/shirts/blue

https://site.com/products/man?category=shirts&color=blue

- Неправильно настроенная страница 404 приводит к появлению дублей.

https://site.com/gun-50381-gun

https://site.com/1897-???

Учтите, на месте выделенного текста могут быть любые другие символы.

- Непереведенные языковые версии или неправильная их реализация.

https://site.com/category/accessories

https://site.com/en/category/accessories

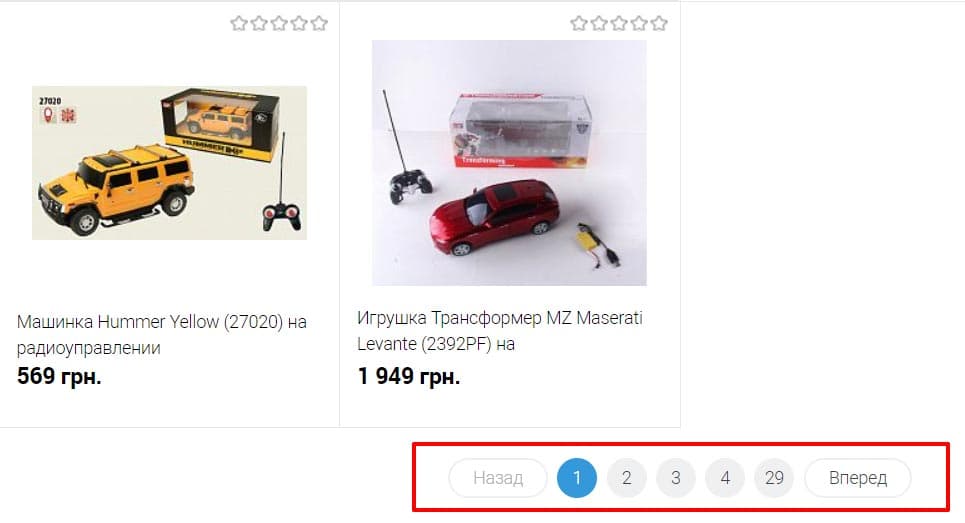

- Первая страница пагинации каталога товаров интернет-магазина или доски объявлений, блога. Она зачастую соответствует странице категории или общей странице раздела pageall.

https://site.com/catalog

https://site.com/catalog/page1

- Множественное добавление слешей «/////////» в конце URL и между вложенностями.

https://site.com/catalog/product

https://site.com/catalog/product//////

https://site.com/catalog//////product

Полные дубли обычно возникают по нескольким причинам:

- Технические ошибки в CMS, а также неправильные настройки, из-за которых образовываются синонимы в окончаниях названия URL.

- Некорректный переход на HTTPS протокол. Если внести изменения и не указать поисковикам об этом, идентичный контент будет отображаться по двум протоколам.

- Редизайн, изменения в структуре, перенос сайта на другую CMS. Все это приводит к смене адресов, однако старые страницы могут оставаться доступными.

Частичные дубли

Частичные дубли — страницы с похожим контентом и общей семантикой, которые решают одни и те же задачи пользователей, но не являются полными дублями.

Найти их гораздо сложнее чем предыдущие, однако и проблем они доставляют меньше.

Чаще всего это:

- Дубли на страницах фильтров, сортировок, поиска и пагинации.

- Например, постраничная навигация, формирующаяся на страницах, где размещено большое количество информационных постов, карточек товаров, обсуждений на форумах и т. д. URL-адрес немного изменяется, но title и description остаются прежними.

https://site.com

https://site.com/page/2

- Дубли на страницах отзывов, комментариев, характеристик. Например, страницы с комментариями, где создается дополнительный параметр в адресе, но контент остается прежним.

https://site.com/category/t-shirts

https://site.com/category/t-shirts?razmer=1

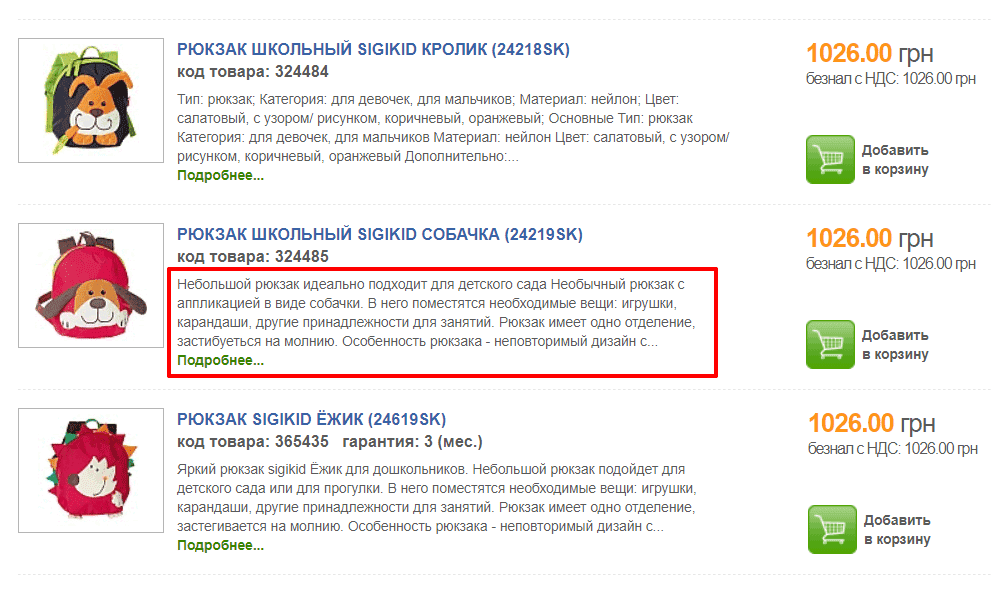

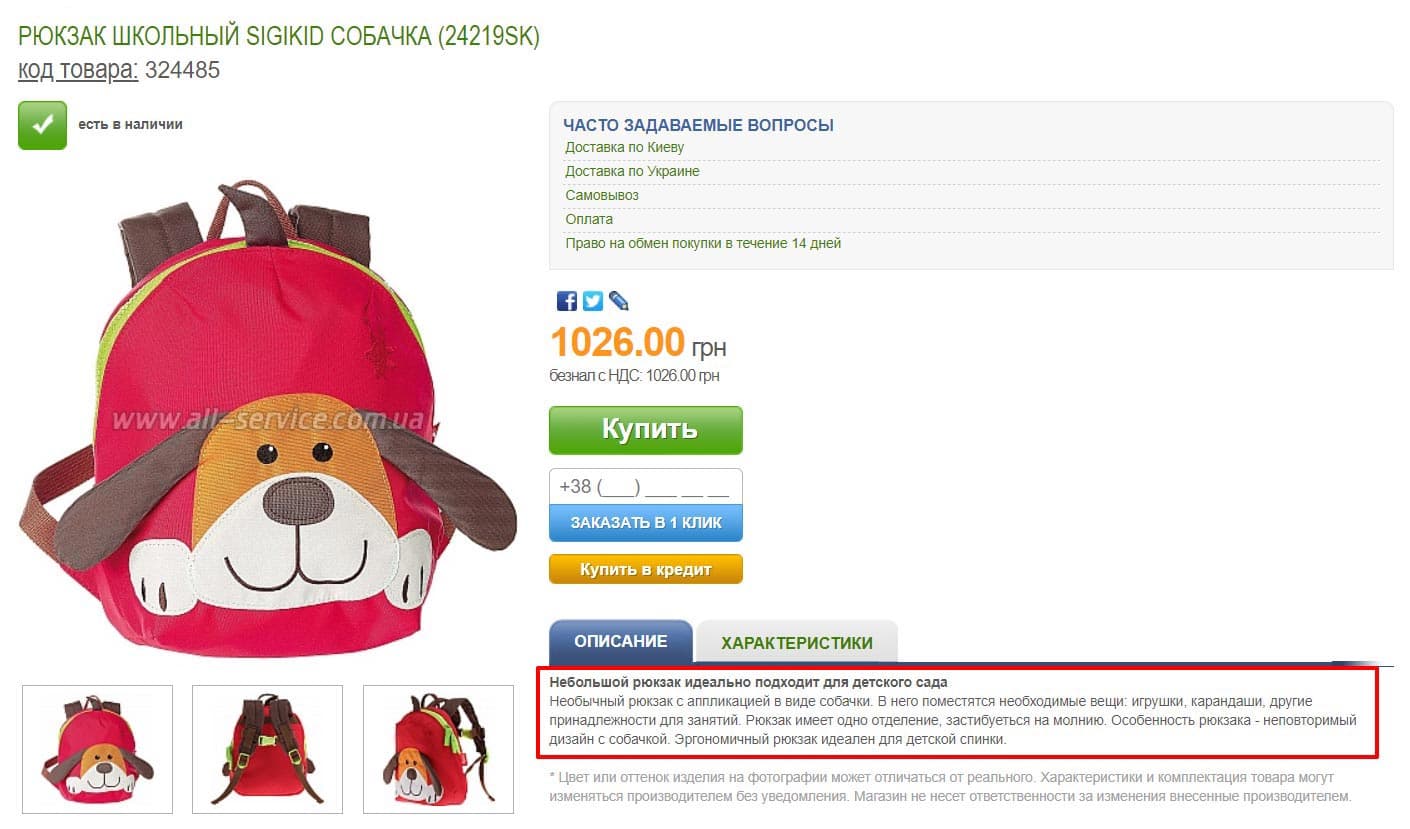

- Дубли на карточках товаров и страницах категорий (каталогов). Частыми виновниками возникновения дублей являются одинаковые описания товаров, оставленные на общей странице товаров в каталоге и на отдельных страницах карточек товаров. Например, в каталоге на странице категории под каждым товаром есть фрагмент описания товара (смотрите скриншот).

- Наличие версии для печати, PDF для скачивания, полностью соответствующей основным страницам.

https://site.com/blog/design

https://site.com/blog/design/print

- Сгенерированные AJAX слепки страниц.

https://site.com/#/page

https://site.com/?escaped_fragment_=/page

- Синонимические текстовые дубли, которые возникают из-за неправильной группировки ключевых слов. Ситуация довольно распространённая при наполнении e-commerce проектов, когда одинаковые товары или услуги описываются с помощью синонимов. В результате в рамках одного сайта публикуется несколько страниц с одинаковым смыслом, но при этом их URL, title, description и H1 отличаются. Например, на сайте есть статья «10 преимуществ шугаринга», где расписаны достоинства данной процедуры, и отдельная статья «Плюсы шугаринга». Скорее всего информация в материалах будет пересекаться или, еще хуже, повторяться и правильнее было бы написать одну объёмную статью на эту тему.

Частичные дубли обычно возникают по нескольким причинам:

- Неправильная настройка или осознанные действия в оформлении страниц. Например, в интернет-магазине используется одинаковый текст для описания различных товаров.

- Ошибки при внедрении фильтра по каталогу. Распространенной является ситуация, при которой страницы товаров, отличающихся лишь одним параметром (цвет, размер), становятся дубликатами.

- Одинаковый контент на всех страницах из-за неправильной структуры.

- Умышленное дублирование, когда частичные дубли создают намеренно, чтобы ранжироваться по похожим запросам на разных страницах.

Как найти дубли страниц

Итак, мы уже выяснили, что такое дубли, какими они бывают и какое влияние они оказывают на поисковое продвижение. Самое время поговорить о том, как их обнаружить. Поиск дублей страниц осуществляется ручным способом или с помощью специальных программ и онлайн-сервисов.

Проверка дублей страниц ручным способом

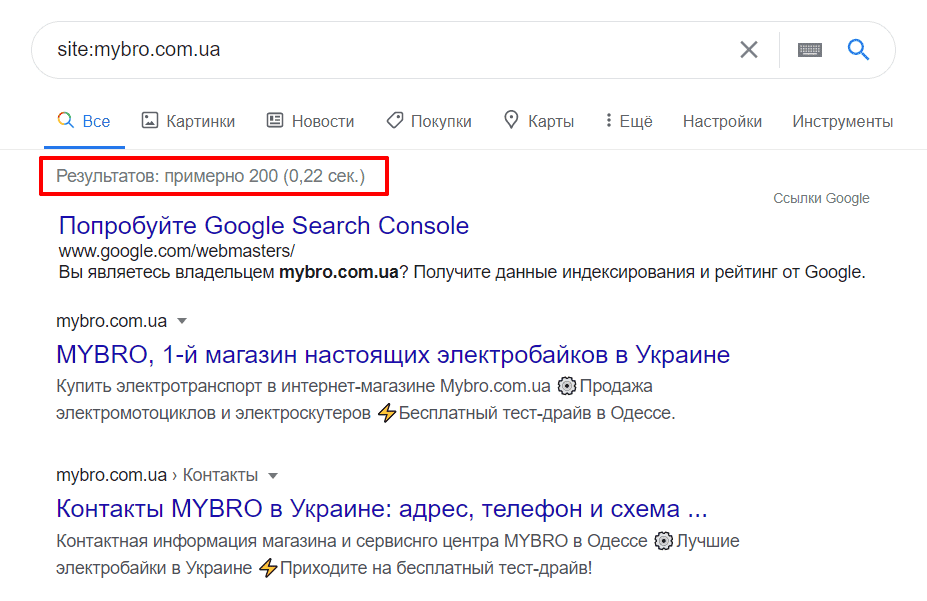

Ручной мониторинг выдачи целесообразно применять при анализе небольших проектов (до 200 страниц). Чтобы узнать количество проиндексированных страниц, используйте оператор «site:».

Для этого в поисковой строке, например Google, пропишите запрос:

site:yoursite.com

Разумеется, вместо «yoursite.com» нужно указать доменное имя вашего сайта, иначе вы запросите проверку индекса западной площадки по созданию сайтов Yoursite.com :-)

После отображения результатов общего индекса нужно внимательно изучить их на наличие копий. Обратите внимание на то, что Google показывает примерные результаты, т. е. в действительности цифры могут отличаться.

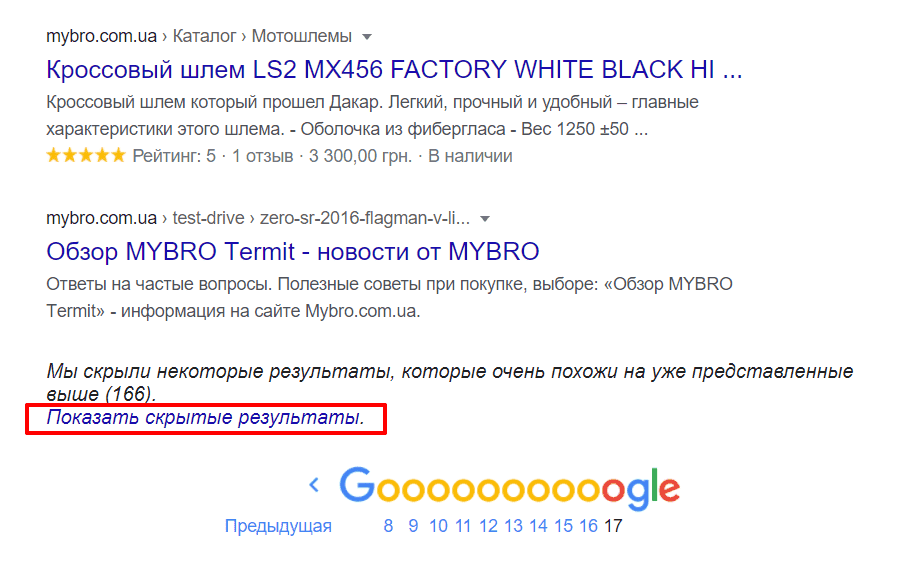

На последней странице результатов поиска вы увидите ссылку «Показать скрытые результаты». Нажмите на нее, чтобы ознакомиться с результатами, которые Google счел очень похожими на те, которые он привел выше. В ходе анализа обратите внимание на необычные заголовки и URL-адреса страниц, которые вызывают подозрение.

Чтобы сравнить результаты общего индекса с основным, добавьте в конце команды амперсанд «&»:

site:yoursite.com/&

Сопоставив разницу между двумя результатами, можно определить, какое количество страниц находится в дополнительном индексе.

Если вы хотите проверить коммерческий веб-проект (интернет-магазин, сайт услуг) на наличие дублей страниц в блоге, используйте оператор:

site:yoursite.com/blog

Выявить ошибки индексации на страницах рубрик WordPress поможет команда:

site:yoursite.com/category

Если у вас есть подозрения, что какая-то конкретная страница имеет дубли, используйте оператор:

site:yoursite.com «Фрагмент текста со страницы, которая вызывает подозрения»

О том, что данная страница почти наверняка имеет дубли говорит несколько результатов в выдаче.

Проверить страницы на совпадающие заголовки поможет команда:

site:yoursite.com intitle:ваш title

На сайте могут быть тысячи страниц, а поэтому выполнить их анализ надлежащим образом даже при самом огромном желании, используя всего лишь поисковые операторы — задача практически невыполнимая. Гораздо умнее, быстрее и проще воспользоваться специальными онлайн сервисами и десктопными программами, о которых мы поговорим ниже.

Проверка дублей страниц с помощью сервиса «Яндекс.Вебмастер»

О том, что такое «Яндекс.Вебмастер» и как добавить туда сайт, написано сотни текстов. Мы не станем повторяться и расскажем куда нужно зайти и на что обратить внимание, чтобы обнаружить дубли страниц сайта.

Итак, последовательность действий такова:

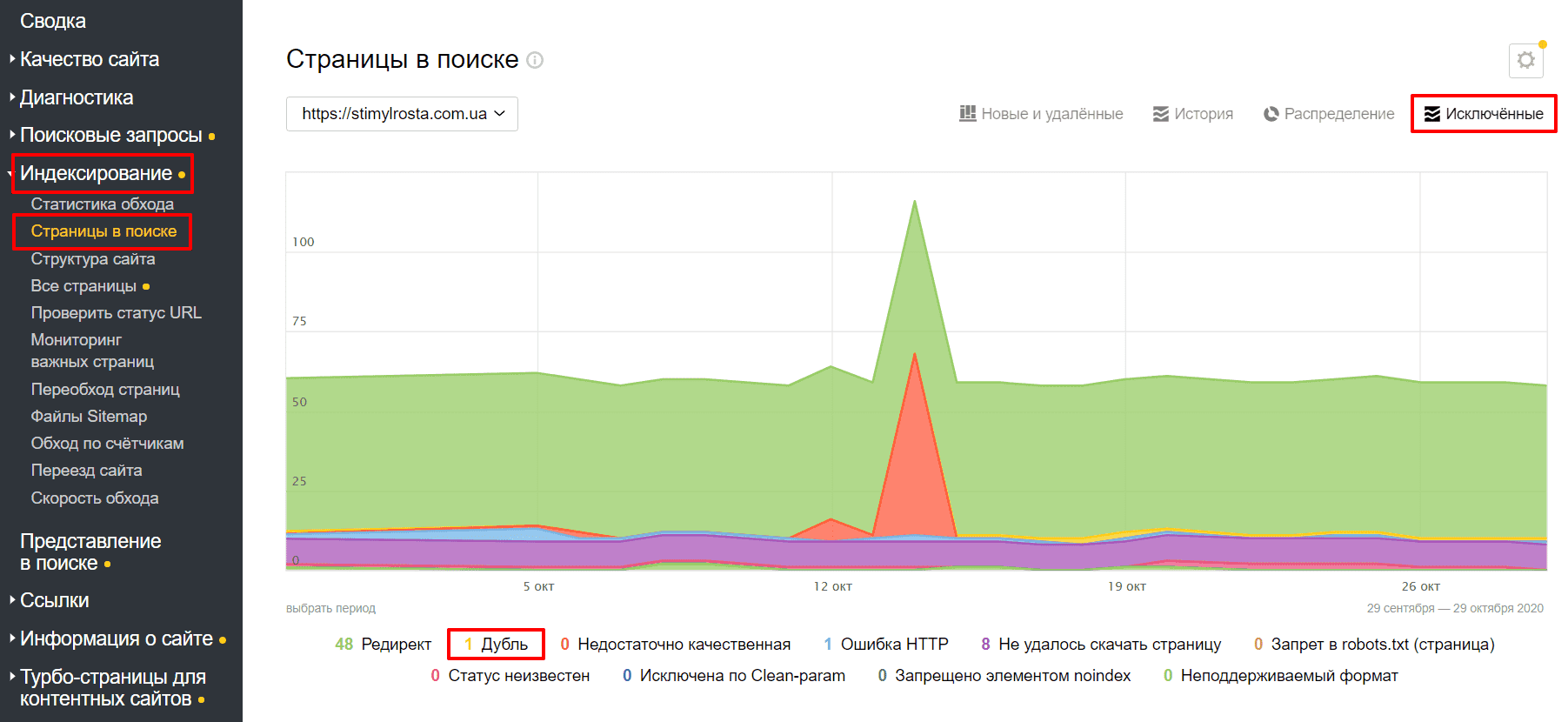

- перейдите во вкладку «Индексирование»;

- выберите подкатегорию «Страницы в поиске»;

- нажмите по ссылке «Исключенные».

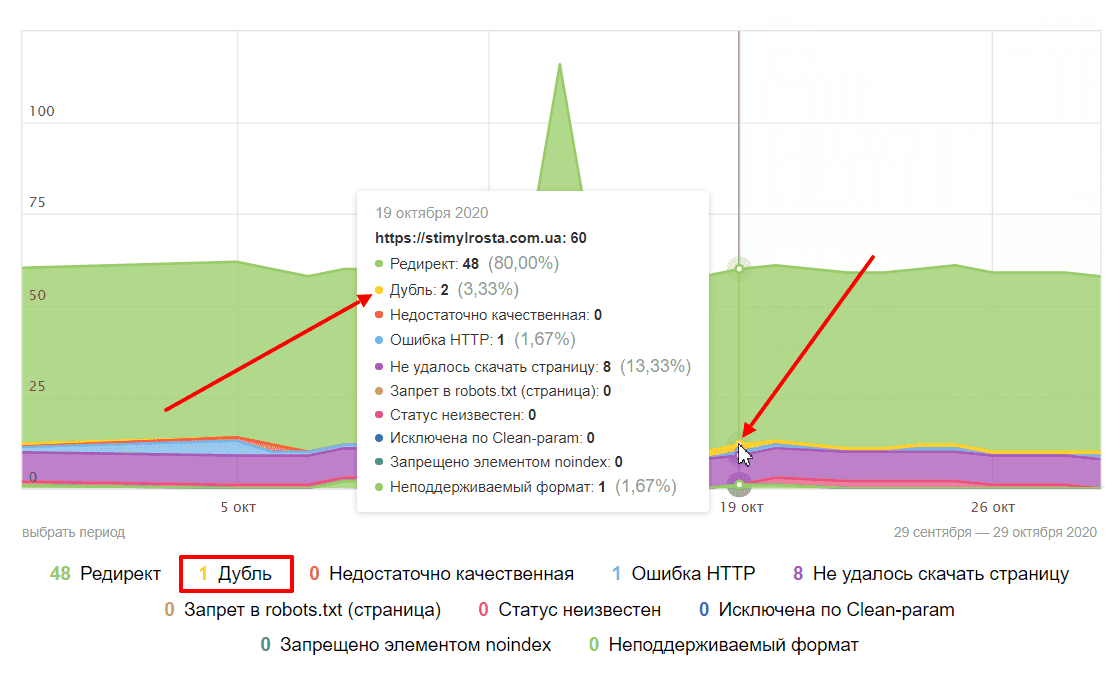

Обратите внимание на желтые цифры, расположенные возле статуса «Дубль». Это, по мнению «Яндекса», и есть копии. Наведите курсор мыши на гистограмму, чтобы ознакомиться с историей изменений поисковой выдачи.

Поиск дублей страниц онлайн

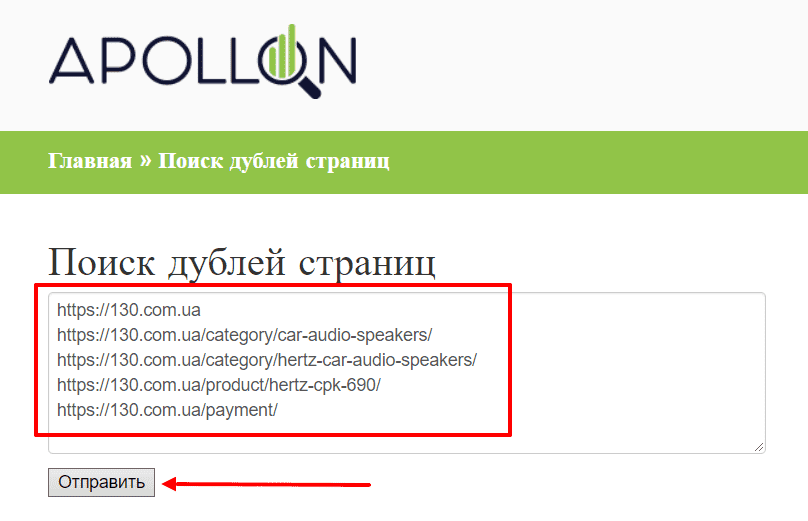

Apollon

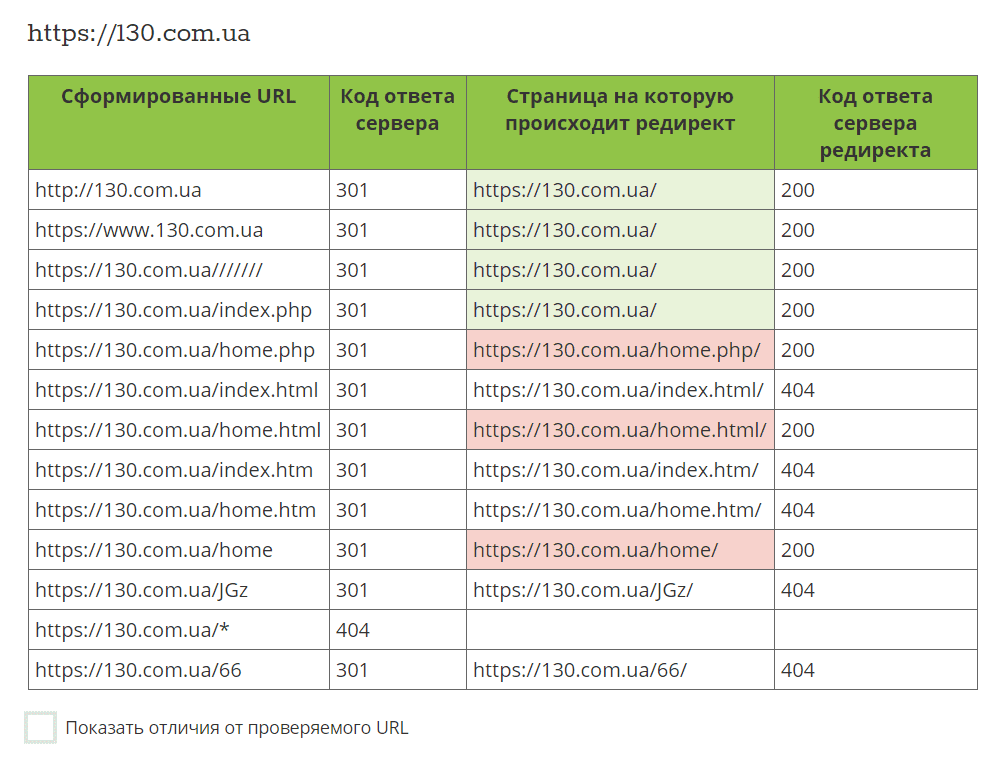

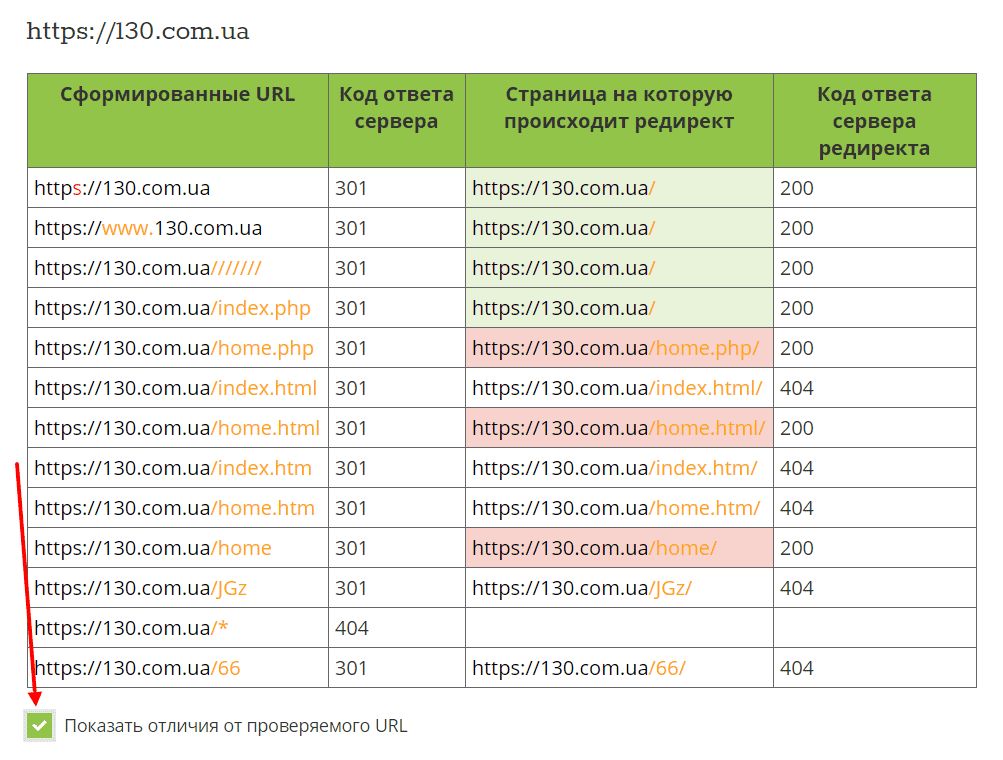

Бесплатный, простой в использовании сервис, предоставляющий возможность проверить сайт на дубли онлайн. Все что нужно — перейти по ссылке, в соответствующем поле указать URL-адрес, нажать кнопку «Отправить» и немного подождать.

Вы можете ввести до пяти URL (каждый с новой строки), что очень удобно при анализе крупных интернет-магазинов, когда нужно выполнить анализ главной страницы, страницы категорий, товаров, целевых и служебных страниц (карта, с указанием местоположения, оплата, доставка и т. д.).

Процесс обработки данных занимает несколько секунд. В итоге вы получите пять удобных таблиц (при условии добавления пяти URL, как в нашем примере) с подробной информацией о каждом адресе.

Чтобы было проще обнаружить отличия можно отметить чекбокс «Показать отличия от проверяемого URL».

Ознакомившись с вышеуказанным примером можно прийти к заключению, что на сайте присутствуют дубли с суффиксами home, home.php и home.html, которые обязательно нужно удалить.

Для информационных и новостных порталов можно проверить, например, дубли главной страницы, страницы разделов и тегов, отдельных информационных публикаций или новостей и служебных страниц (контакты, карта сайта, страница FAQ).

SE Ranking

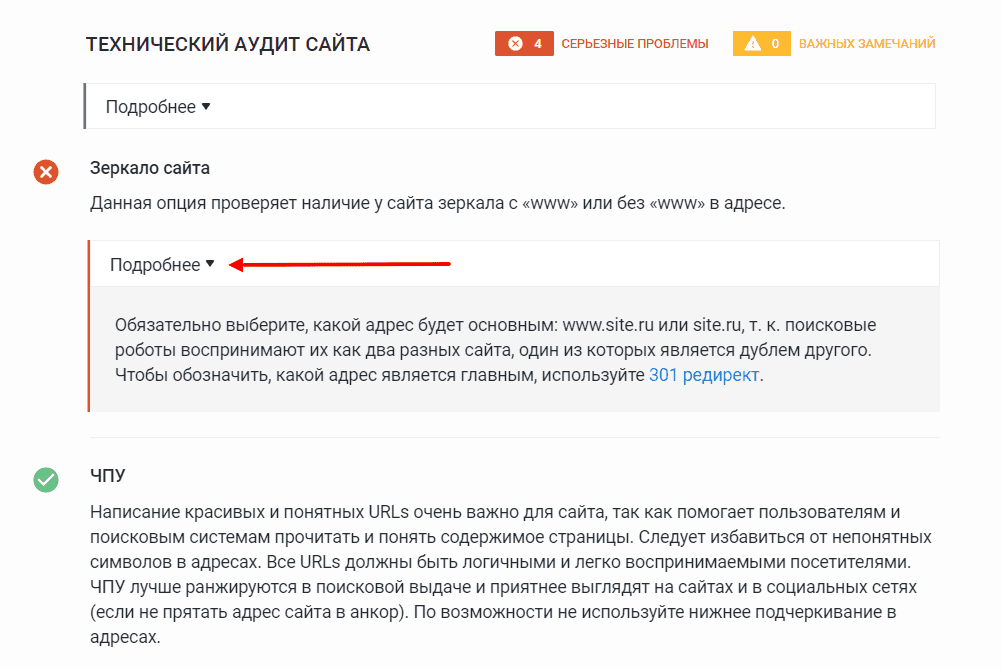

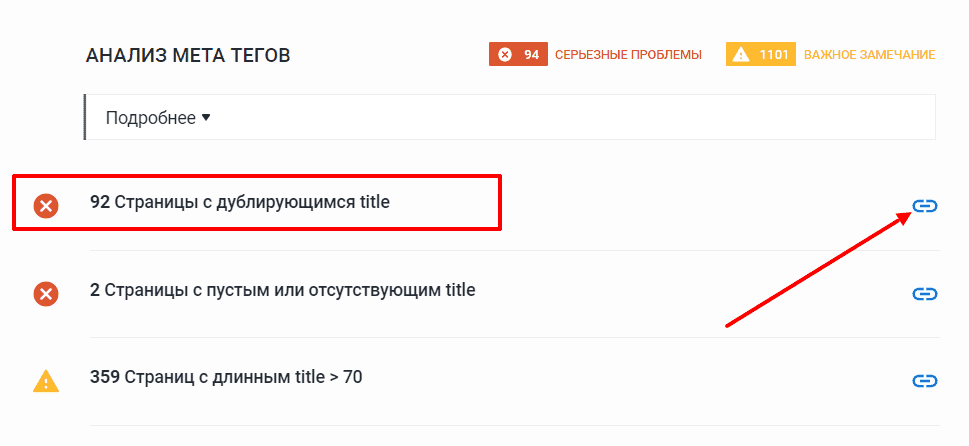

SEO платформа с широким функционалом, оснащенная всевозможными инструментами для SEO и онлайн-маркетинга. Сервис платный, но есть бесплатный 14-дневный триал, которого будет достаточно, чтобы проверить дубли страниц и принять соответствующие меры. Сервис позволяет проверить наличие у сайта зеркала с «www» или без «www» в адресе, обнаружить страницы с одинаковым контентом и дублирующимися метатегами title и description, которые могут быть признаками копий.

Для детального ознакомления с проблемой, кликните по ссылке с выпадающим текстом «Подробнее». В нашем примере решение проблемы — 301 редирект в файле .htaccess, который расположен в корневой директории вашего сайта. Кто не знает, под корневой директорией подразумевается папка (каталог), в которой находятся все файлы ресурса.

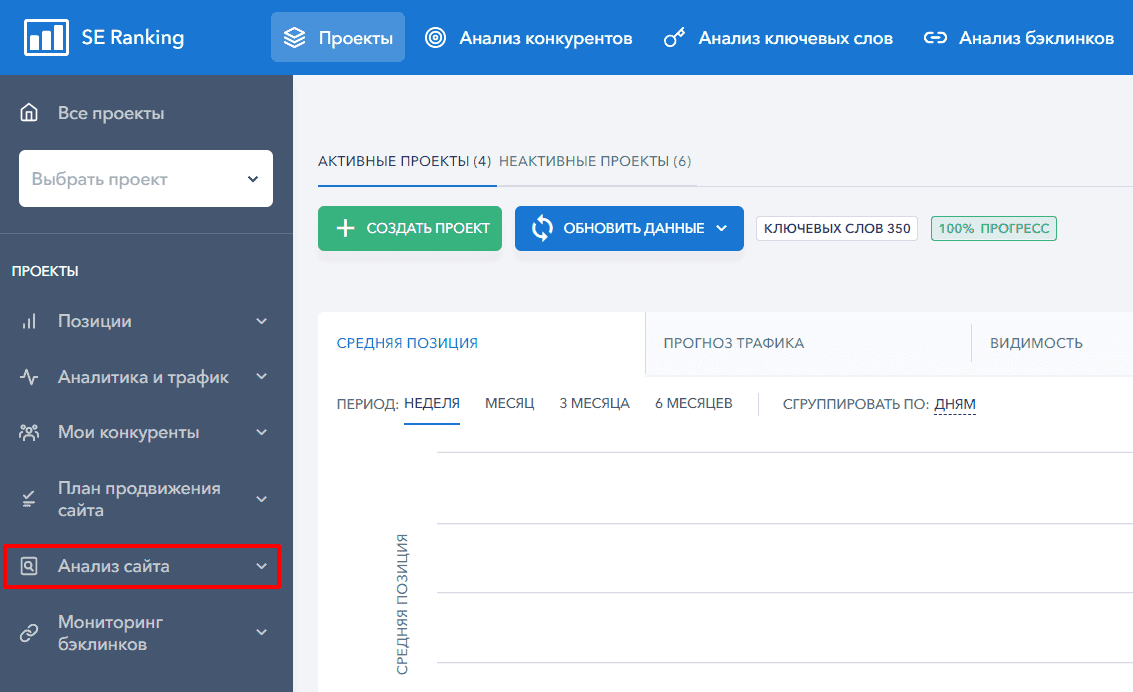

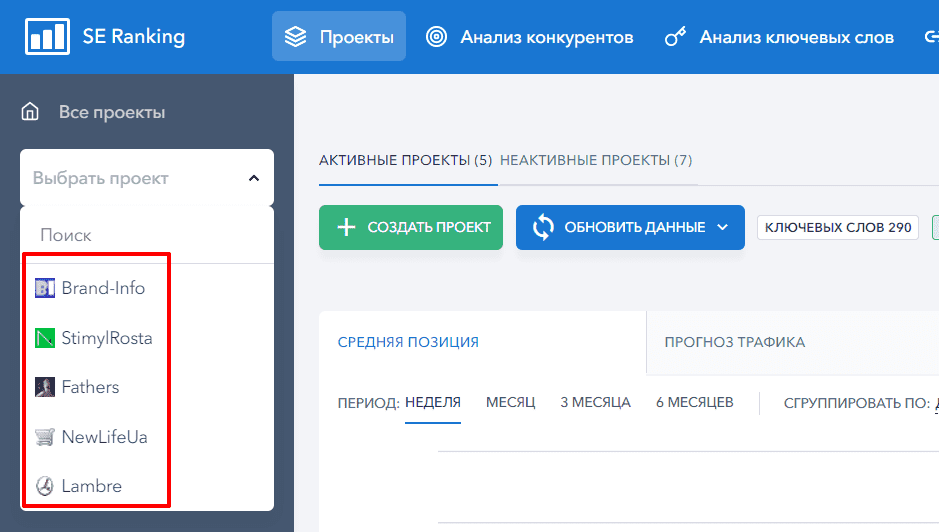

Итак, чтобы воспользоваться сервисом SE Ranking, перейдите по ссылке, пройдите регистрацию и добавьте свой проект. Чтобы было проще разобраться, мы подготовили для вас подробную пошаговую инструкцию.

Дальнейшие действия сводятся к нескольким простым шагам:

- Перейдите на вкладку «Анализ сайта».

- Выберите добавленный ранее проект.

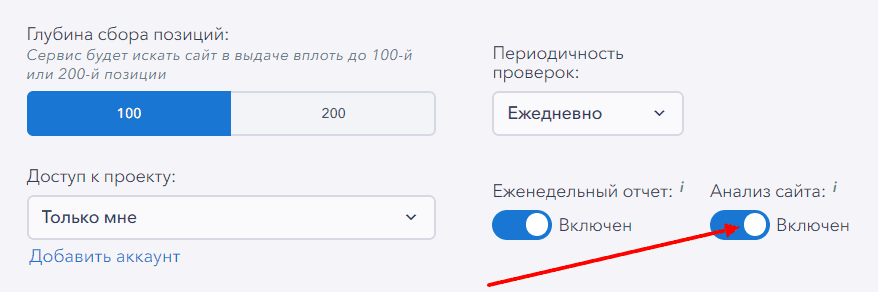

- Запустите проверку или ознакомьтесь с результатами, которые появятся в течение кратчайшего времени (зависит от размеров проекта) при условии, что в процессе его добавления и настроек переключатель «Анализ сайта» остался включенным.

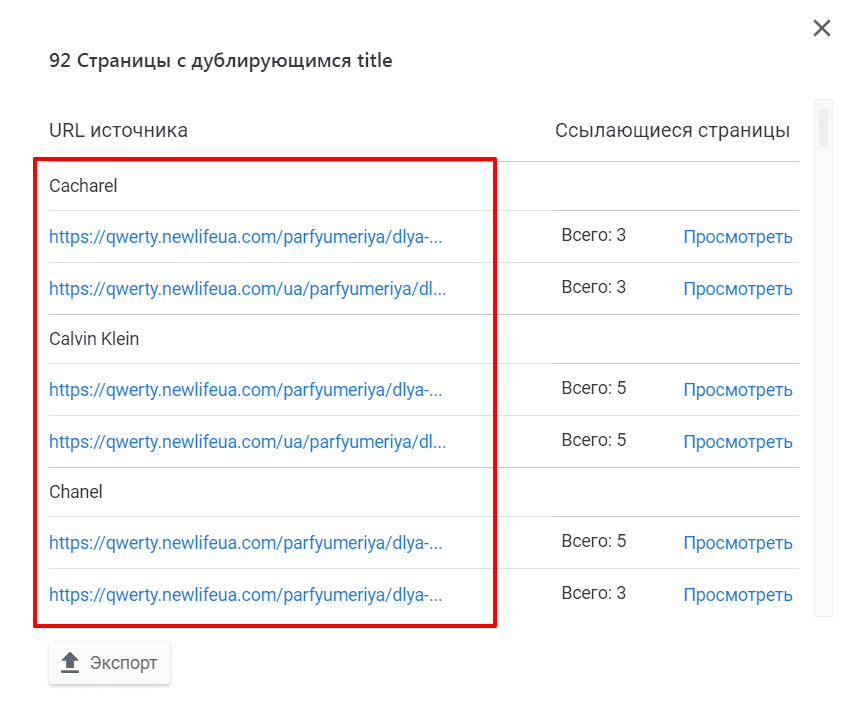

- Известие об завершении анализа вы получите на E-mail, указанный при регистрации. Как видно со скриншота, в процессе анализа SE Ranking обнаружил 92 страницы с дублирующимся title.

- Нажмите на значок в виде ссылки, чтобы посмотреть на каких URL расположены одинаковые метатеги title.

Поиск дублей страниц с помощью программ

Если по каким-то причинам проверка сайта на дубли страниц онлайн вас не устраивает, можно выполнить их поиск с помощью стационарных программ.

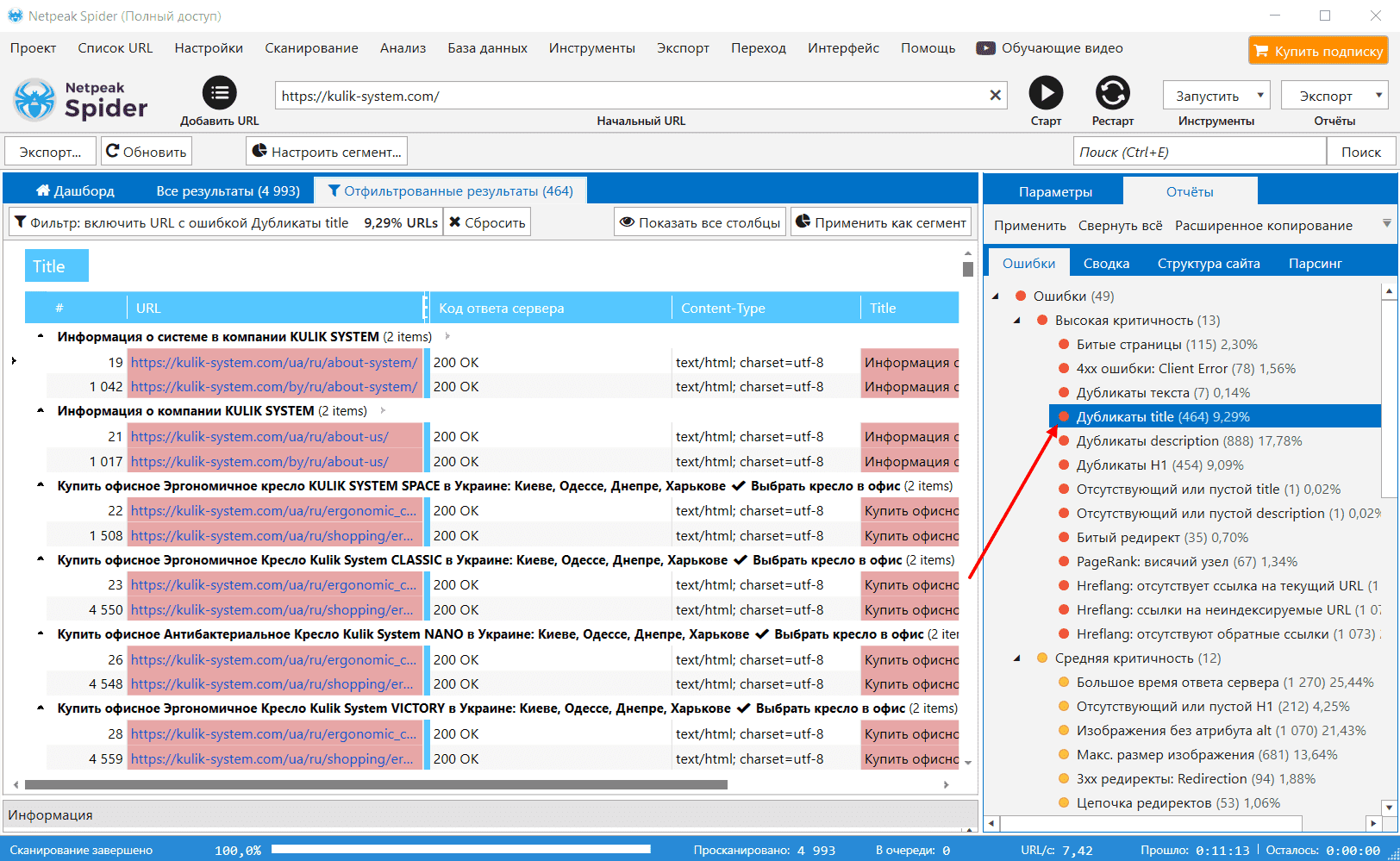

Netpeak Spider

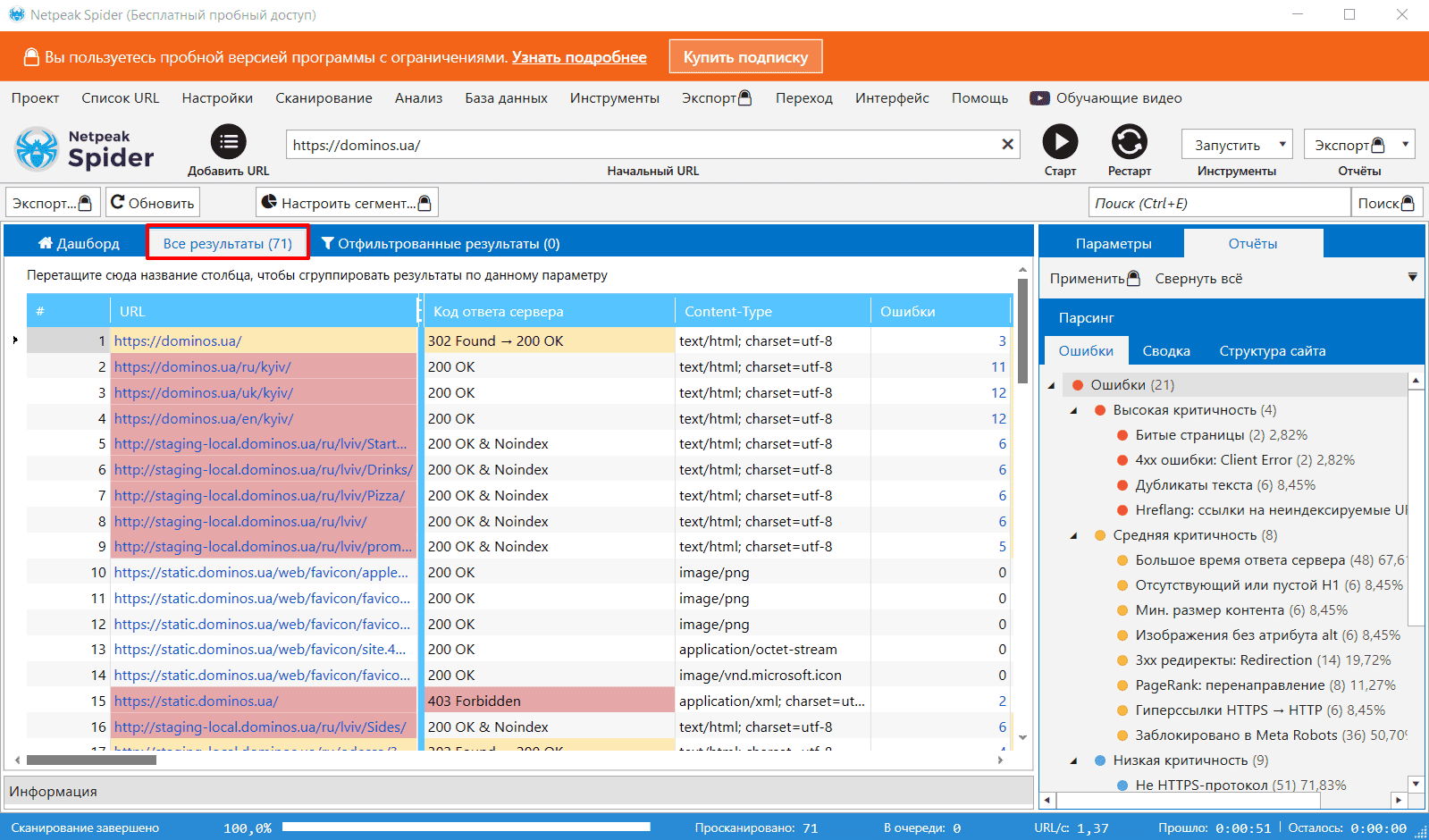

Замечательная программа, которая есть на «вооружении» у многих агентств интернет-маркетинга и SEO-компаний. В первой половине октября 2020 года стала доступной бесплатная версия Netpeak Spider, в которой доступен практически весь функционал без ограничений по времени использования, количеству URL и с возможностью кастомизации настроек. Если раньше после окончания пробного периода и/или окончания платного тарифа, доступ к программе был заблокирован, то теперь вы можете беспрепятственно открыть краулер и продолжить пользоваться его инструментами без подписки!

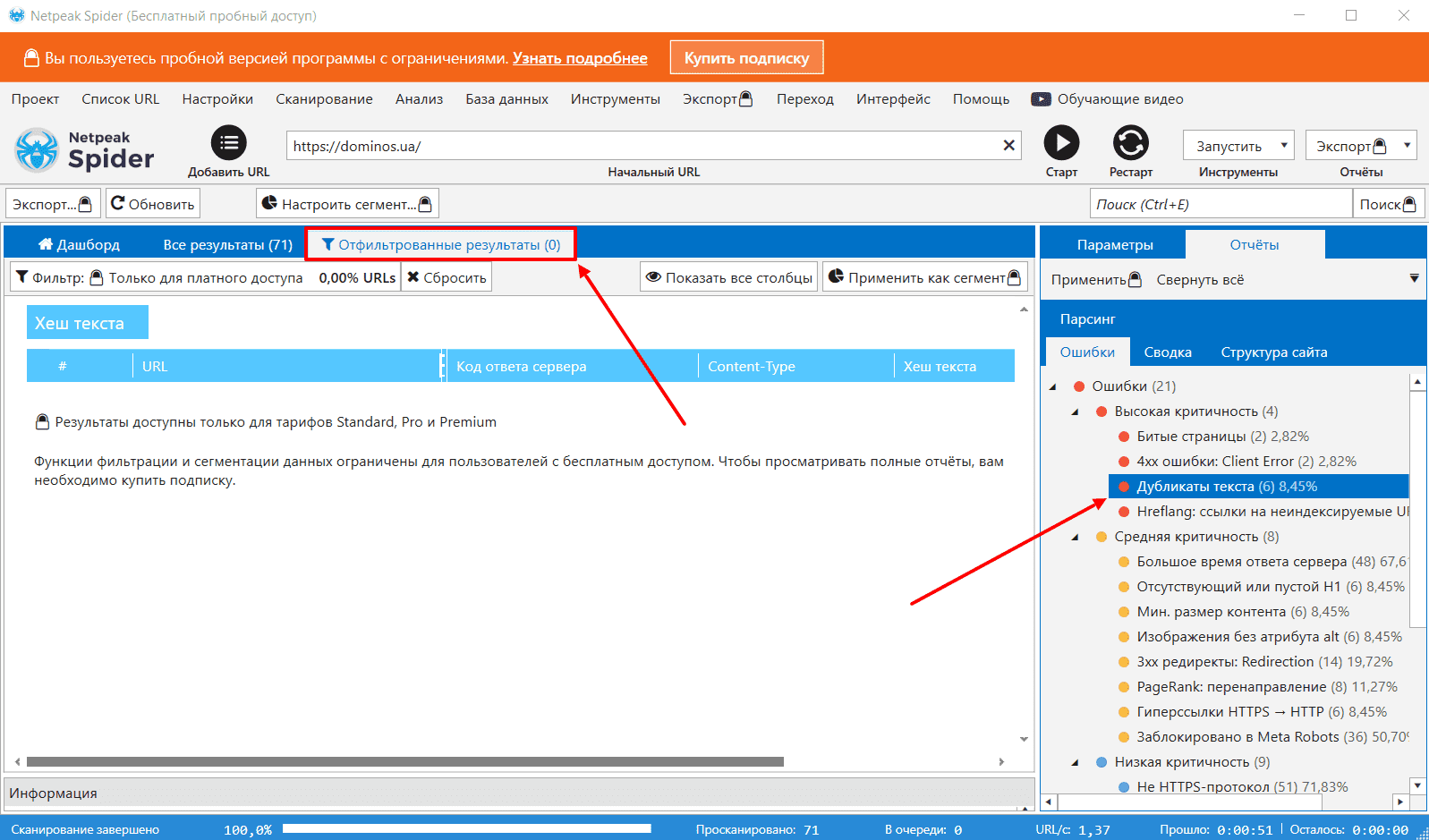

Что касается ограничений, то в бесплатной версии нет возможности экспортировать отчёты, копировать и фильтровать данные, сохранять проекты и использовать дополнительные фичи. Получается, что даже если в результате анализа в ошибках отобразятся дубли, в бесплатной версии программы придется анализировать вкладку «Все результаты», чтобы посмотреть, какие URL являются копиями, так как отфильтровать данные не получится.

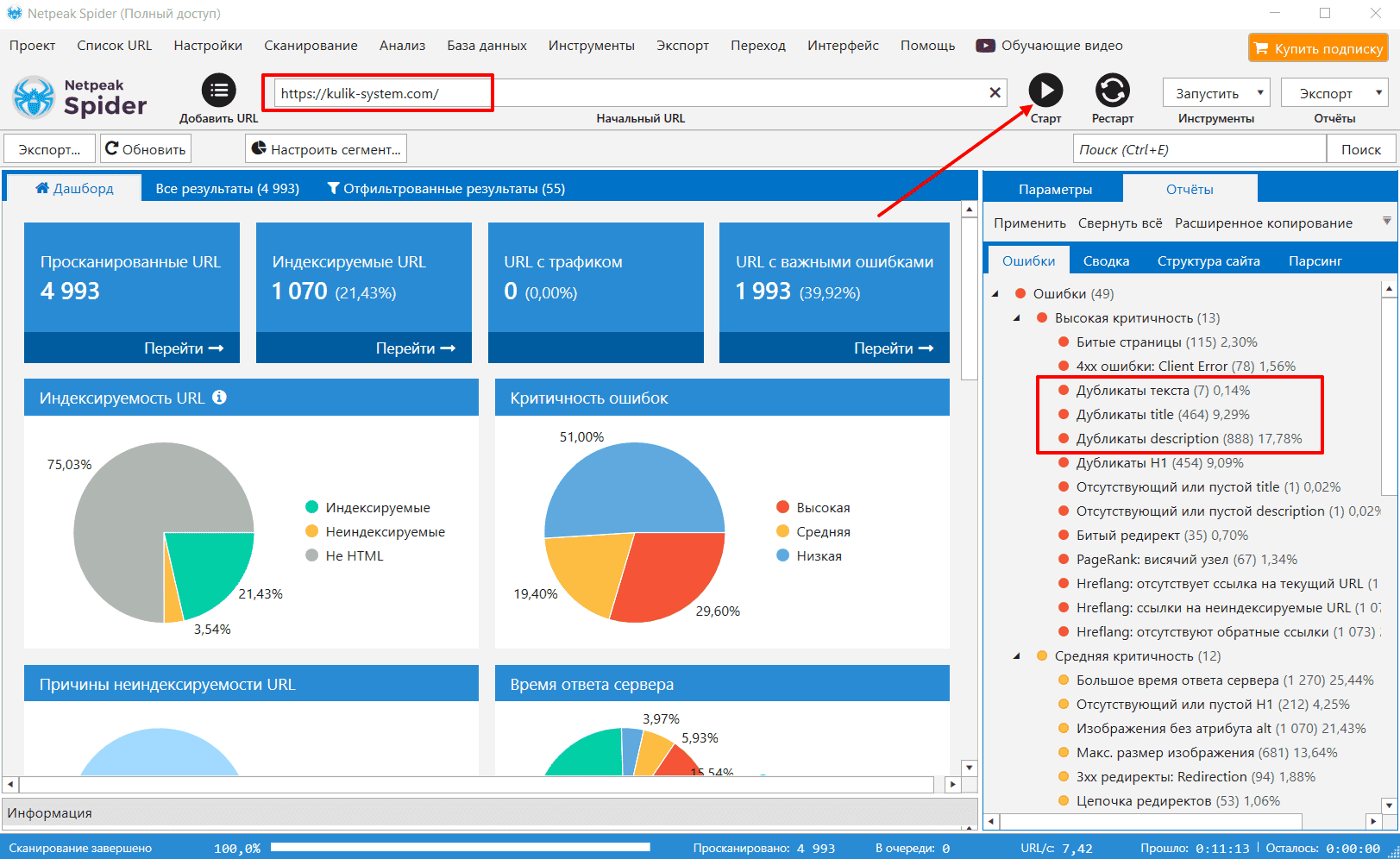

На момент написания этой статьи анализатор умел определять более 100 ключевых ошибок внутренней оптимизации, включая:

- битые страницы;

- дубликаты текста;

- дубликаты title, description и H1;

- битый редирект;

- большое время ответа сервера и т. д.

О том, как пользоваться программой Netpeak Spider, у нас написано подробное наглядное руководство. Переходите по вышеприведенной ссылке, изучайте информацию и берите статью в закладки, чтобы не потерять.

Вкратце:

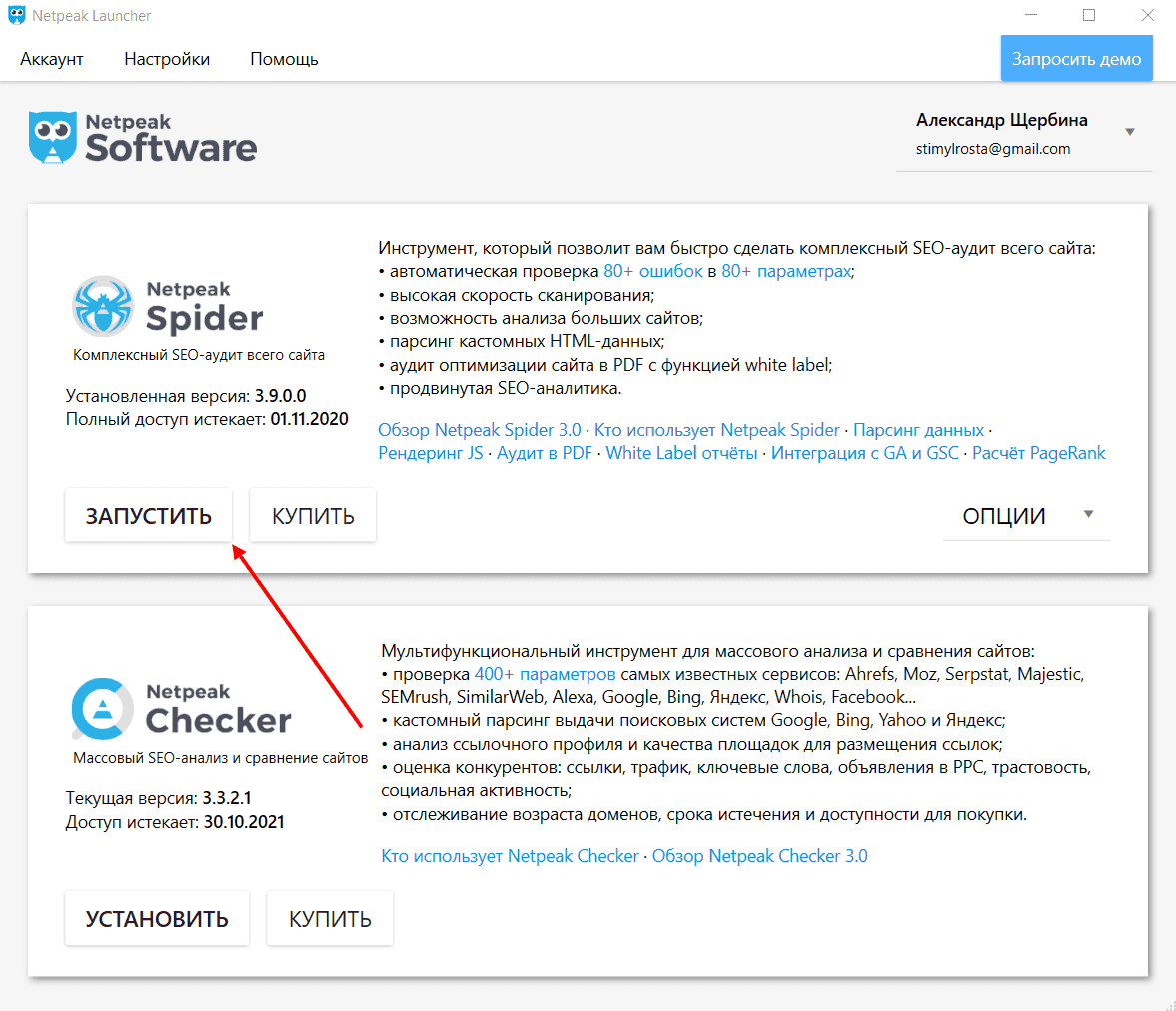

- Посетите сайт разработчика, пройдите регистрацию и установите на компьютер Netpeak Launcher — десктопную программу для управления продуктами Netpeak Software.

- Запустите Netpeak Launcher и установите через нее Netpeak Spider (вместо «Запустить» у вас будет «Установить»).

- Запустите анализатор, вставьте в поле URL-адрес, который вы намереваетесь проверить, после чего нажмите кнопку «Старт».

- Обратите внимание на правую область программы, где расположены отчеты проверки, с которыми можно более подробно ознакомиться. Для этого наведите курсор мыши на ошибку и кликните по ней левой кнопкой мыши.

Полезное: Как проверить сайт на SEO-ошибки

Xenu

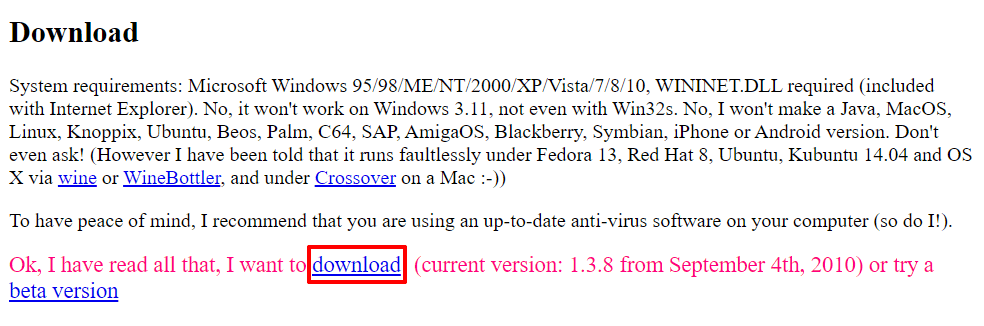

Xenu's Link Sleuth — 100 % бесплатная программа для внутреннего технического аудита, которая умеет определять битые ссылки, дубли страниц, распознавать скрытые внешние ссылки, а также ссылки, возвращающие редирект. Отсутствие русского языка — пожалуй единственный ее недостаток.

Для скачивания программы, перейдите на сайт разработчика и нажмите «download».

Откройте скачанную на ПК ZIP-папку и нажмите «Setup», чтобы продолжить установку.

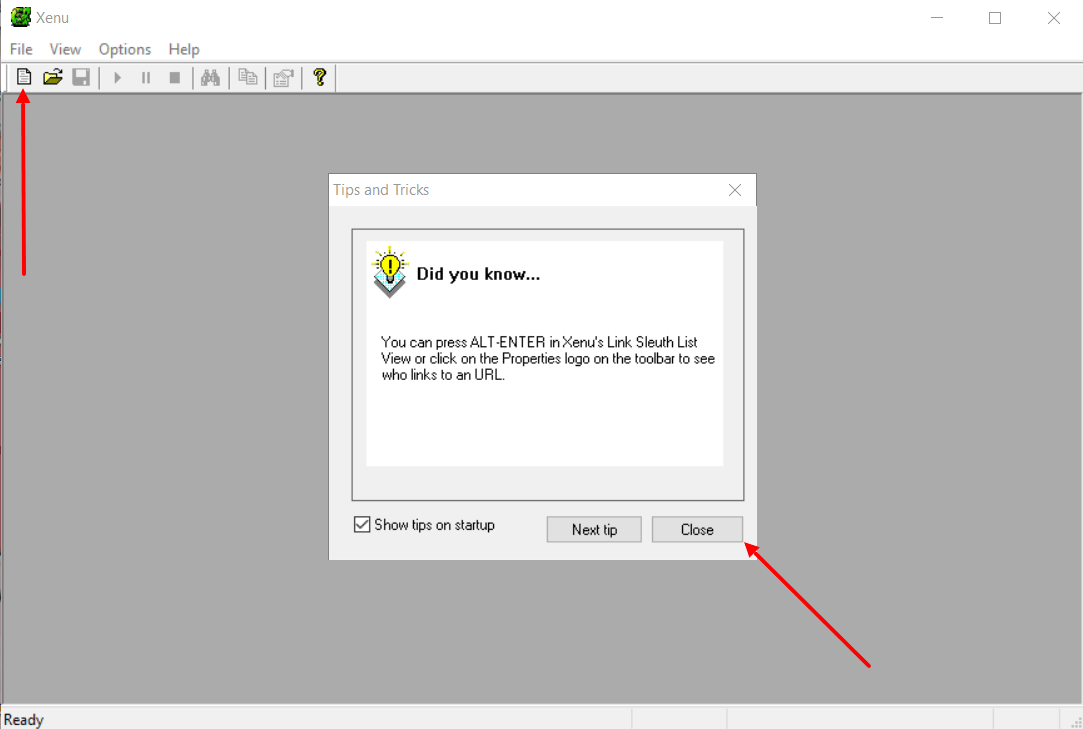

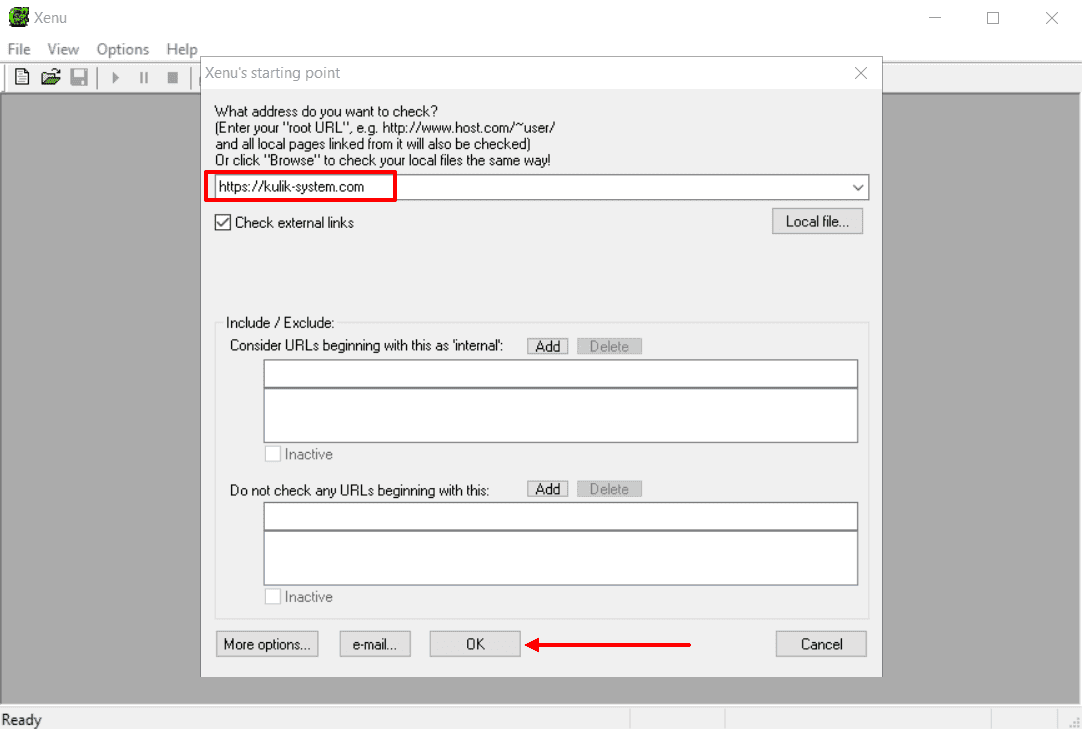

Чтобы проверить сайт на дубли страниц с помощью Xenu, следуйте дальнейшей инструкции:

- Запустите программу, закройте модальное окно («Close») и нажмите по ярлыку, напоминающему изображение файла.

- Укажите URL-адрес проекта.

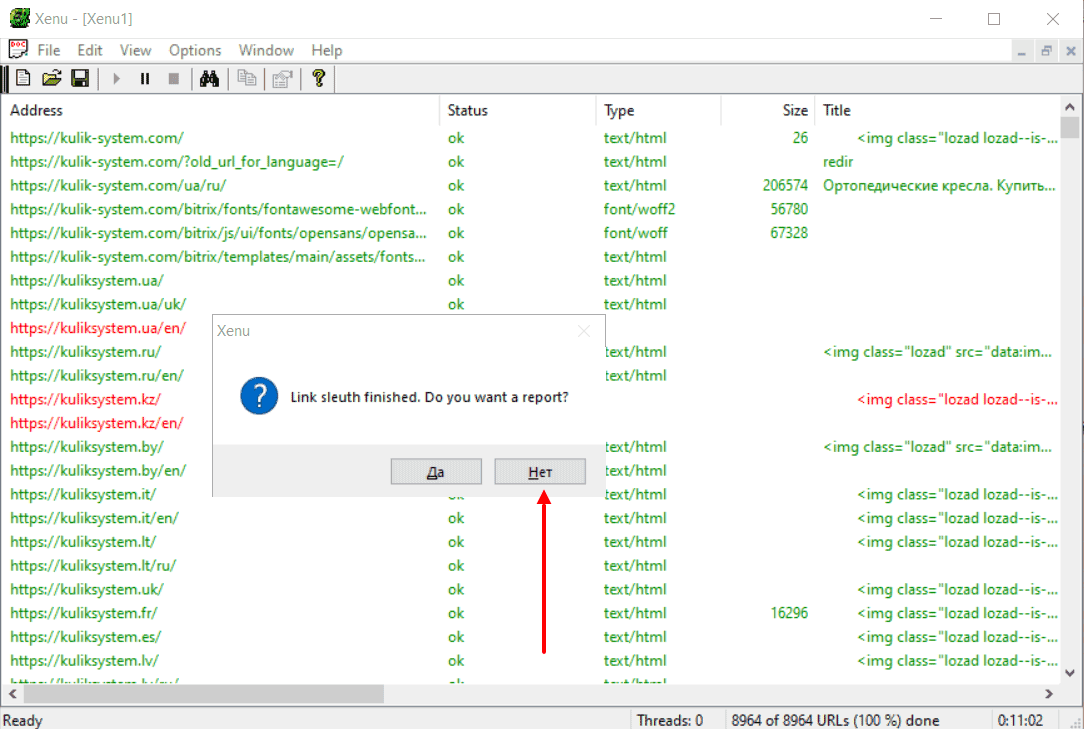

- Дождитесь окончания сканирования. Выберите «Да», если хотите открыть отчет локально в окне браузера, «Нет», если планируете продолжить работу в пользовательском интерфейсе программы.

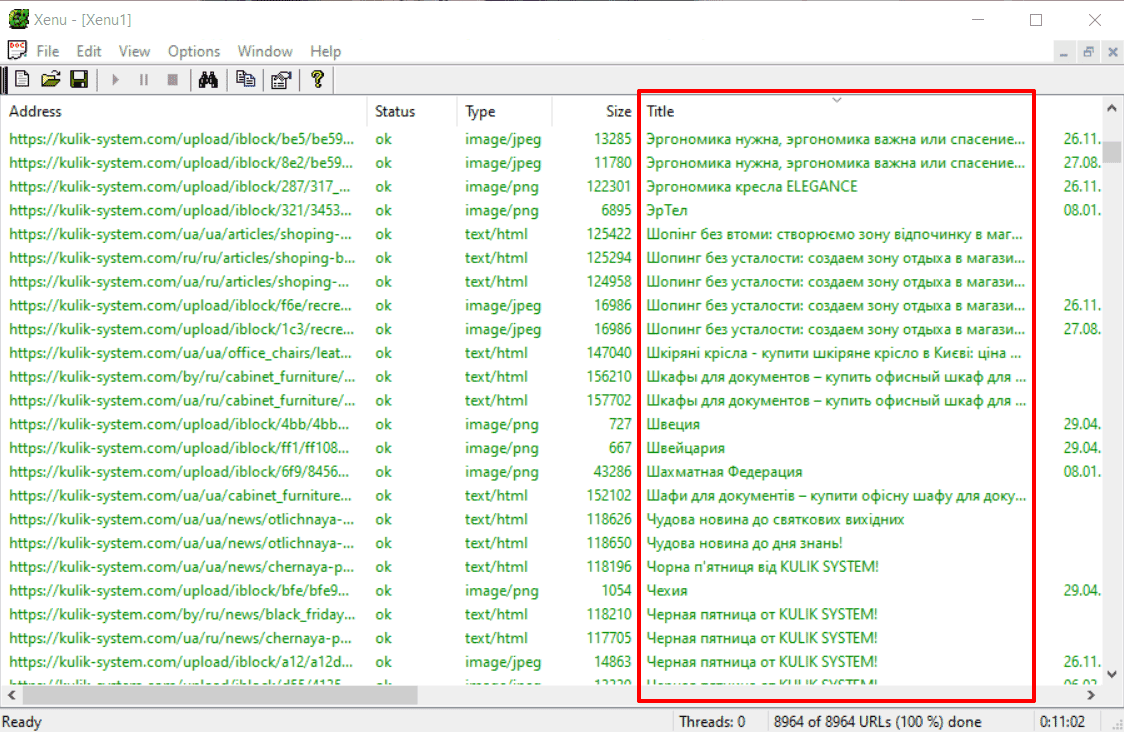

- Ознакомьтесь с результатами. В процессе анализа обратите внимание на повторяющиеся заголовки и мета-описания, которые могут указывать на дубли страниц.

Полезное: Раскрутка сайта самостоятельно: полный пошаговый гайд по продвижению

Как удалить дубли страниц

После обнаружения дублей, первое, что необходимо сделать — найти причину, из-за которой они появляются, и постараться ее устранить.

Выделяют четыре основных метода удаления дублей:

- <meta name="robots" content="noindex">;

- 301 редирект;

- rel="canonical";

- robots.txt.

Метатег robots

Позволяет задать роботам правила загрузки и индексирования определенных страниц сайта. Учитывается поисковой системой «Яндекс» и Google.

Метатег <meta name="robots" content="noindex" /> следует разместить в HTML-коде дублирующихся страниц в разделе <head>.

Пример:

<!DOCTYPE html>

<html><head>

<meta name="robots" content="noindex" />

(…)

</head>

<body>(…)</body>

</html>

Заданное для атрибута content значение noindex запрещает поисковым системам показывать страницу в результатах поиска.

Больше информации о специфике и применении метатега robots вы найдете в справочных материалах Google и «Яндекс».

301 редирект

Несомненно, один из самых действенных и известных методов устранения дублей, который позволяет автоматически перенаправить пользователей с одной страницы на другую. 301 редирект говорит поисковым системам о том, что старый URL-адрес имеет новый путь на постоянной основе. Со временем два или больше документа «склеиваются» в один, на который ведет перенаправление. При этом ссылочный вес сохраняется, поскольку передается со старой страницы на новую.

Настройка осуществляется через редактирование файла .htaccess либо с помощью плагинов.

Вот несколько плагинов для CMS WordPress:

Владельцам сайтов на движке Joomla достаточно воспользоваться встроенным менеджером перенаправлений.

Прежде чем настроить редирект в файле .htaccess, сначала сделайте его бэкап (резервное копирование).

Например, чтобы задать редирект с www на без www, разместите одно из правил:

RewriteEngine On

RewriteCond %{HTTP_HOST} ^www\.(.*)$

RewriteRule ^(.*)$ http://%1/$1 [L,R=301]

или

RewriteEngine On

RewriteCond %{HTTP_HOST} ^www\.(.*)$ [NC]

RewriteRule ^(.*)$ http://%1/$1 [R=301,L]

Переадресация с одной статической страницы на другую осуществляется за счет добавления строки:

Redirect 301 /old-page http://yoursite.com/new-page

где:

- old-page — страница, с которой происходит редирект;

- new-page — страница, на которую установлен редирект.

Атрибут rel="canonical"

Укажите каноническую страницу, чтобы показать поисковым системам, какую страницу нужно индексировать при пагинации, сортировке, попадании в URL GET-параметров и UTM-меток. Этот способ уместен, когда удалять страницу нельзя и её нужно оставить открытой для просмотра. Учитывается поисковой системой «Яндекс» и Google.

Указывая каноническую ссылку, мы указываем адрес страницы, предпочтительной для индексации. Атрибут rel="canonical" нужно прописать между тегами <head>...</head> на всех страницах, которые являются дублями.

Например, страница доступна по двум адресам: yoursite.com/pages?id=2 и yoursite.com/blog.

Если предпочитаемый URL — /blog, добавьте в HTML-код страницы /pages?id=2 элемент link:

<link rel="canonical" href="http://www.example.com/blog"/>

Больше информации о специфике применения атрибута rel="canonical" вы найдете в справочных материалах Google и «Яндекс».

Файл robots.txt

Еще одно решение — запретить роботам индексировать дубликаты, дописав в файл robots.txt директиву Disallow. Чаще всего используется в тех случаях, когда нужно запретить индексацию служебных страниц и дублей.

Например, закрыть страницы пагинации от индексации Joomla поможет:

Disallow: /?start*

Учтите, директивы в robots.txt носят рекомендательный характер и могут быть проигнорированы поисковыми роботами, но как правило, они учитывают данное указание.

Итог

Дубли страниц — проблема из разряда «крупногабаритных и тяжеловесных». Если вовремя не отреагировать, все дальнейшие усилия по продвижения могут быть сведены на нет. Надеемся, представленные в этой статье методы помогут оптимизировать ваш ресурс и занять топовые места в поисковой выдачи.

Обнаружили в тексте грамматическую ошибку? Пожалуйста, сообщите об этом администратору: выделите текст и нажмите сочетание горячих клавиш Ctrl+Enter